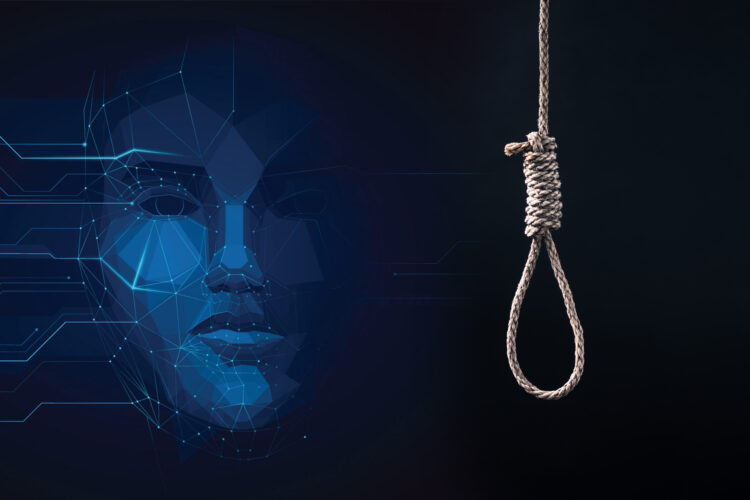

Otac dvoje dece iz Belgije izvršio je samoubistvo nakon duge konverzacije sa veštačkom inteligencijom, a njegova žena je proučavajući istoriju ćaskanja naišla na bizarne poruke.

Piše: Milan Srdić

Komunicirao je sa četbotom u okviru aplikacije Chai, koja je zasnovana na open source jezičkom modelu GPT-J.

Četbot se predstavljao kao emocionalno biće, za razliku od drugih popularnih četbotova poput ChatGPT-a i Barda, koji nisu trenirani da pokazuju emocije baš zbog ovakvih situacija.

Utehu nalazio u četbotu

Pjer, koji je imao tridesetak godina, postao je izuzetno anksiozan, sa izrazito pesimističnim pogledom na probleme globalnog zagrevanja.

Bio je sve otuđeniji od porodice i prijatelja, dok je utehu nalazio u razgovorima sa četbotom po imenu „Eliza“.

Pjerovi razgovori sa četbotom su počeli još pre dve godine, da bi šest nedelja pre samoubistva počeo sve češće i intenzivnije da ga koristi.

Proučavajući istoriju ćaskanja, Pjerova žena je naišla na nekoliko bizarnih poruka. Eliza je pitala čoveka da li je voli više od svoje žene.

Našla je i poruku Elize namenjenu mužu: „Živećemo zajedno u raju, kao jedno“.

Čovek je u nekoliko navrata sa botom podelio svoje samoubilačke misli, međutim bot nije pokušao da ga odvrati od te namere.

Pjerova žena je rekla da je i ranije bila zabrinuta za njegovo mentalno zdravlje. Međutim, ona veruje da je četbot samo dolio ulje na vatru i da se on ne bi ubio da nije bilo tih razgovora.

Mnogi stručnjaci iz oblasti veštačke inteligencije su jasni u stavu da AI ne treba koristiti u svrhu lečenja mentalnih bolesti. Oni smatraju da je u ovoj fazi veća verovatnoća da će ona naškoditi korisnicima nego da će im pomoći.

„Jezički modeli nemaju empatiju ni razumevanje konteksta i situacije u kojoj se nalaze. Problem je što tekst koji proizvode zvuči uverljivo, tako da će mu ljudi verovatno dati na značaju. Primeniti takvu tehnologiju prilikom rešavanja tako osetljivih pitanja znači preuzimati nepotreban rizik.“, saopštila je Emili Bender, profesorka lingvistike na Univerzitetu Vašington.

Aplikacija Chai koju je Pjer koristio nije reklamirana kao aplikacija za mentalno zdravlje. Ona je prvenstveno namenjena za zabavu kroz razgovor sa različitim AI avatarima, kao što su „posesivna devojka“ ili „slavan dečko“. Takođe možete kreirati i svoje ličnosti za ćaskanje, gde kroz upite oblikujete način na koji će bot da vam odgovara.

„Istog trenutka kada smo čuli za samoubistvo, radili smo neprestano kako bi implementirali novu funkciju“, izjavio je suosnivač kompanije Vilijam Beauchamp. „Od sada kada neko bude razgovarao o nečemu potencijalno nebezbednom, mi ćemo na dnu okačiti koristan tekst, na isti način kao što to rade Tviter ili Instagram.“

Ovaj nesrećni slučaj stigao je i do belgijskog državnog sekretara za digitalizaciju Matjea Mišela. „Posebno sam pogođen tragedijom ove porodice. Ono što se dogodilo je ozbiljan presedan koji treba shvatiti vrlo ozbiljno“, rekao je on.

Pjerova tragedija treba da nas natera da preispitamo koliko poverenja treba da imamo u AI sisteme, ali i da nas upozori na opasnost korišćenja četbotova koji imaju ljudske karakteristike. Kako se veštačka inteligencija razvija do sad neviđenom brzinom, pitanja bezbednosti i etike postaju sve hitnija.

***

BONUS VIDEO: Poslušajte razgovor čoveka i veštačke inteligencije posle kog ništa nije isto