Veštačka inteligencija je, bez sumnje, donela revolucionarni način generisanja multimedijalnog sadržaja. Dok su ljudi većinski i dalje zadivljeni sa kojom lakoćom, brzinom i preciznošću je to sada moguće, svima nam preti opasnost od poplave lažnih i zlonamernih sadržaja koji trajno mogu da ugroze reputaciju ili unište život žrtve.

Kao što je manipulacija fotografijama kroz Photoshop bila senzacija početkom ovog veka, tako je sada u prvom planu takozvani „dipfejk“. Tu spadaju lažni video i audio sadržaji koji oponašaju izgled, mimiku ili glas neke druge osobe, toliko uverljivi da u nekim slučajevima prosečno oko ne primeti razliku.

Sam naziv „deep“ označava da se u pozadini kriju algoritmi dubokog mašinskog učenja koji se treniraju na ogromnim setovima podataka i bezbroj slika.

Uzmimo za primer video u kojem se pojavljuje virtuelni klon Morgana Frimana, jednog od najpoznatijih svetskih glumaca. Budite realni, da ste video našli na društvenim mrežama, gde je pažnja na detalje žrtvovana zarad količine informacija, da li biste primetili da je u pitanju lažnjak?

Naravno, snimci još uvek nisu savršeni. Za one obazrivije, postoje detalji koji otkrivaju da postoji još prostora za napredak, poput sinhronizacije usana sa glasom, pokreta zenica i mutnih tranzicija pri naglim pokretima, naročito kada osoba okrene lice tako da se vidi profil.

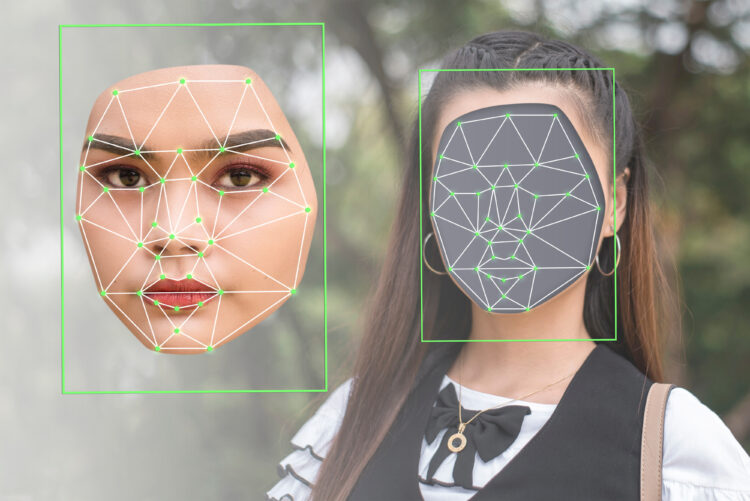

Najčešće se dipfejkovi zasnivaju na dubokim neuronskim mrežama koje omogućavaju tehniku zamene lica.

Prvo je potrebno pronaći video koji će se koristiti kao osnova, a zatim se prosleđuje kolekcija video klipova i slika osobe koju želite da umetnete u prvobitni video. Klipovi uopšte ne moraju biti povezani, oni mogu biti isečci iz filma ili klipovi sa Jutjuba. Program analizom osobe iz više uglova mapira lice i postavlja ga na aktera u željenom snimku.

Iako deluje kao veoma osetljiv i kompleksan posao, postoje javno dostupni alati poput kineske aplikacije Zao, DeepFaceLab, FakeApp i mnogih drugih aplikacija otvorenog koda koje se nalaze na GitHabu.

Većina revolucionarnih inovacija u ljudskoj istoriji, od atomske energije do interneta i društvenih mreža, ima dve strane medalje: osim što mogu doneti društveni i ekonomski napredak, one olakšavaju posao malicioznim ljudima i kriminalcima koji su korak bliže svom cilju. Sa dostupnim alatima za kreiranje dipfejkova, sve više ljudi ima priliku da primeni svoju kreativnost u neetičke svrhe.

Možda i najveća opasnost preti od osvetničke pornografije, generisane bez pristanka druge osobe. Što je više dostupnih slika kojim bi se algoritam mogao nahraniti, to je opasnost veća jer je snimak verodostojniji. Sudeći po izveštaju kompanije Deeptrace iz 2019. godine, čak 96% pronađenih dipfejk videa je bilo pornografskog sadržaja.

Primena dipfejkova je veoma široka, ona se može koristiti i u zabavne, šaljive svrhe. Tako je, na primer, osvanuo snimak gde Mark Zakerberg priznaje da mu je cilj da manipuliše svojim korisnicima, ili gde bivši predsednik Amerike, Barak Obama, vređa Donalda Trampa.

Postoje i oblasti gde tehnologija dipfejka može olakšati posao i uštedeti novac. Određeni AI alati su sposobni da od nule naprave autentičnu virtuelnu lutku koja je istovetna kao i čovek. Neki su ih već oprobali u ulozi voditelja, a nije isključeno ni da će se primenjivati u filmskoj industriji za dubliranje glumaca, obrazovanju i simulacijama.

Međutim, granica između zabave i zlonamernog korišćenja je veoma osetljiva.

Na internetu postoje brojni primeri dipfejkova gde neki od najpoznatiji svetskih političara daju kontraverzne i lažne izjave. Tehnologija srećom nije dovoljno uznapredovala da daje istovetne rezultate, pa se propusti mogu primetiti. Inače, zamislite kakve bi društvene posledice usledile ako bi svako mogao da „ubacuje reči u usta“ uticajnim ljudima.

Kao najopasniji primer zloupotrebe se pojavio snimak predsednika Ukrajine Vladimira Zelinskog, koji u proleće 2022. godine, nedugo nakon početka rata u Ukrajini, poziva svoje vojnike da se predaju. Snimak je izazvao veliku paniku, ali je srećom brzo razotkriven.

I mi u Srbiji imamo problem

I mi u Srbiji imamo primere takve zloupotrebe, a televizija Pink je otišla korak dalje i jedan od snimaka pustila na nacionalnoj frekvenciji. Subjekti ismevanja su bili predstavnici opozicije Dragan Đilas, Marinika Tepić i Vuk Jeremić. Iako je za većinu ljudi naizgled uočivo da se radi o lažnjaku, ocena je bila da je neprihvatljivo je da se na ovaj način manipuliše političkim protivnicima.

Kada se sve sabere i oduzme, čini se da potencijalne zloupotrebe prevazilaze koristi koje bi se dobile korišćenjem dipfejk tehnologije. Lažirani porografski snimci već sad izgledaju veoma uverljivo, a ukoliko se popravi sinhronizacija glasa sa usnama, predstoji nam velika opasnost gde se više neće moći verovati praktično ničemu što je na internetu. Kada se na to doda činjenica da mnogi ljudi nisu ni svesni za postojanje dipfejk fenomena, jasno je da se otvara veliki prostor za manipulisanje.

BONUS VIDEO: